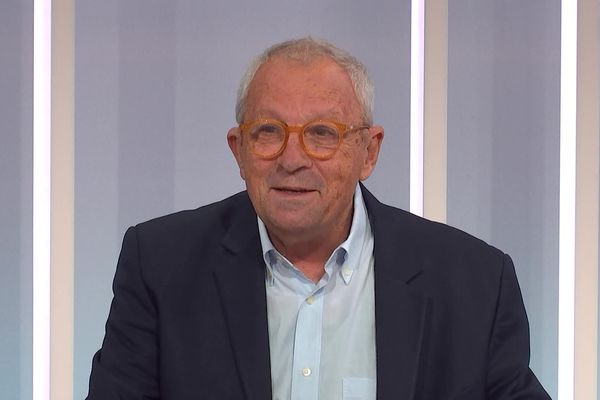

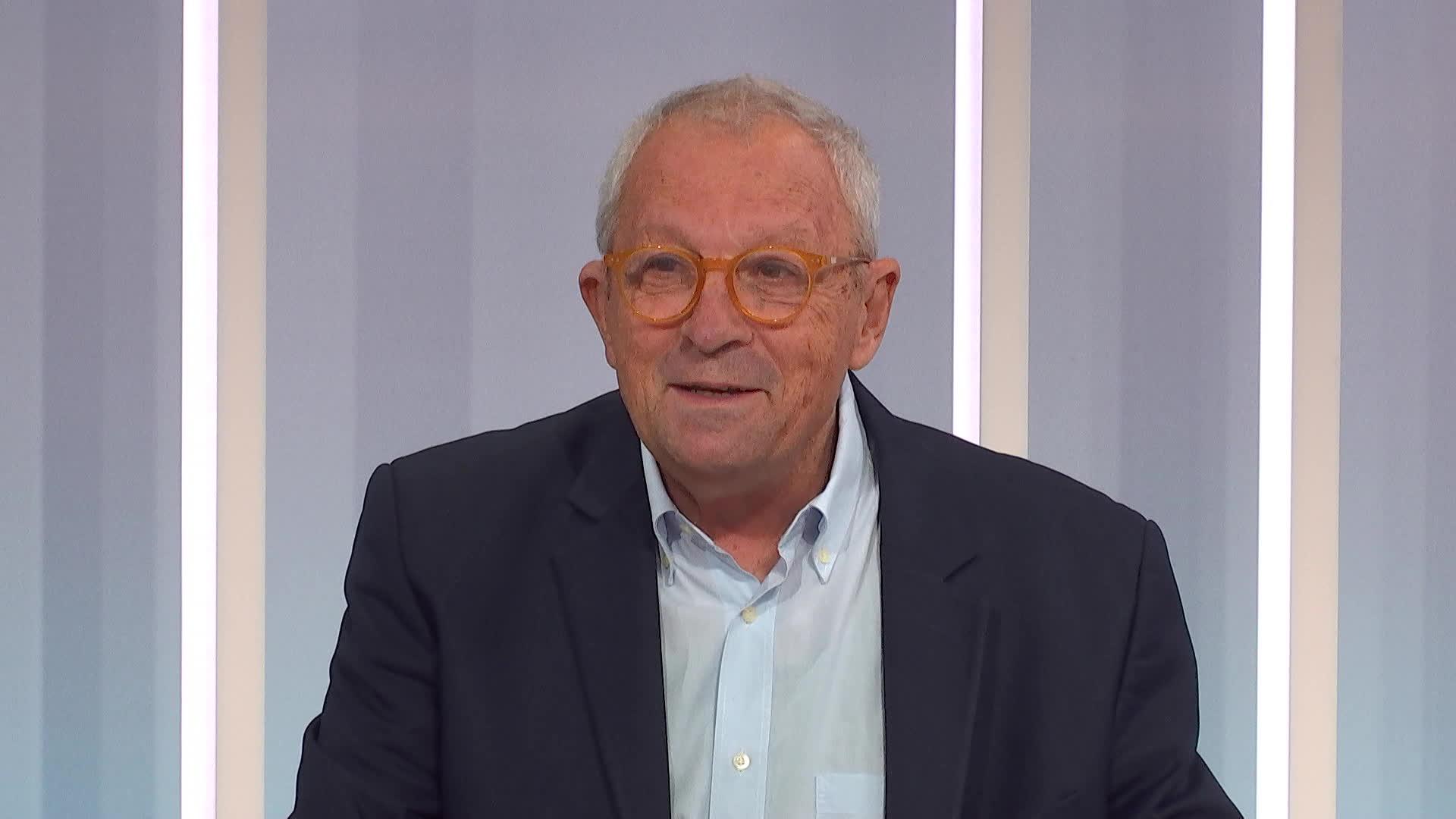

Le chercheur grenoblois Joseph Sifakis, premier Français récompensé par le prix Turing en 2007, l'équivalent du prix Nobel en informatique, a signé le moratoire sur l'intelligence artificielle. Il met en garde contre les risques de "dépendance" et de "déresponsabilisation" générés par des robots comme ChatGPT. Entretien.

Il fait partie des spécialistes à demander une pause dans le développement d'outils comme ChatGPT. Comme de nombreuses personnalités du monde des nouvelles technologies, il a signé le moratoire sur l'intelligence artificielle. Joseph Sifakis, directeur de recherches au CNRS à Grenoble, est le premier Français à avoir reçu le prix Turing, l'équivalent du Prix Nobel en informatique, en 2007.

France 3 Alpes : "Vous avez signé le moratoire sur l'intelligence artificielle, parce que la technologie va trop vite ?

Joseph Sifakis : On m'a envoyé le texte, je n'avais pas le loisir de le modifier, mais j'étais d'accord avec l'idée principale qu'il faut se donner un temps de réflexion. La technologie va trop vite par rapport à ce que l'on peut assimiler, comprendre, analyser.

Cela veut dire qu'on a brûlé des étapes ?

Oui. Il faut qu'il y ait une maturation dans l'esprit des gens sur les conséquences possibles. On voit qu'il y a des discussions à ce sujet aux Etats-Unis, dans l'Union Européenne et dans tous les pays.

Sur quelles problématiques faut-il prendre du recul ?

Je pense que le problème, c'est l'accès de ChatGPT, ou de tout outil équivalent, aux enfants parce que, s'ils ont accès à cette technologie pour faire leurs devoirs d'école, ils chercheront la facilité. Or, c'est très important pour un enfant d'apprendre à réfléchir, d'apprendre à calculer, de ne pas être dépendant d'une technologie et de pouvoir prendre des décisions de façon responsable.

En quoi ChatGPT diffère-t-il de Google ?

Google vous trouve des informations, mais ne fait pas de synthèse, ne résout pas de problèmes, ne répond pas à des questions précises. Vous pouvez demander à ChatGPT de faire un devoir pour vous et peut-être qu'il le fera mieux que vous. Donc, un écolier ou un lycéen peut demander à ChatGPT de faire son devoir et, ça, c'est extrêmement dangereux.

Le danger ce n'est pas que les machines deviennent plus intelligentes que nous mais, que nous, nous devenions trop dépendants des machines

Joseph Sifakis.

Il faut, pour former le caractère de l'enfant, pour cultiver son intelligence et sa créativité, le laisser travailler tout seul. Avoir accès à Google, c'est différent. L'enfant aura des informations, mais il n'aura jamais de texte rédigé qui réponde à des questions précises. ChatGPT propose des discours relativement bien construits, qui peuvent présenter des contradictions, mais qui sont vraisemblables.

Quel est l'intérêt de ChatGPT ?

Pour quelqu'un de relativement mûr, ChatGPT peut l'aider à avancer plus vite dans son travail mais en même temps cela crée une certaine dépendance et on ne sait pas jusqu'où cela peut aller. Je prends cette image : vous avez un esclave qui exauce tous vos vœux, qui fait tout ce que vous voulez. Vous aurez une tendance naturelle à lui demander tout ce qu'il peut faire mais vous devenez très dépendant. Ce qui caractérise la nature humaine, c'est une dimension essentielle, c'est de pouvoir prendre des décisions de façon responsable. Et ça peut aussi conduire l'homme à se déresponsabiliser.

Je l'ai dit dans mon livre (Understanding and Changing the World, From Information to Knowledge and Intelligence, ndlr) : le danger ce n'est pas que les machines deviennent plus intelligentes que nous mais, que nous, nous devenions trop dépendants des machines, qu'il y ait une aliénation de nos capacités à être productif, à agir de façon responsable, et à exercer notre libre-arbitre.

Les limites entre ce qui est réel et ce qui est fictif s'estompent. Et c'est très grave. Il faut réglementer cela.

Joseph Sifakis.

Les intelligences artificielles donnent des résultats, mais elles ne sont pas transparentes. Si vous l'utilisez pour avoir une secrétaire intelligente pas de problèmes, mais si on commence à les utiliser dans des processus qui prennent des décisions critiques. Là, il faut réfléchir sérieusement. Par exemple, si on l'utilise dans l'administration pour évaluer des gens, les carrières des gens, ou dans les tribunaux, etc. Donc il faut réglementer.

Il y a d'autres dangers. On l'a vu avec les photos du Pape en doudoune, par exemple, diffusée sur les réseaux sociaux...

On peut manipuler des gens. Vous voyez maintenant qu'il y a des sociétés qui commercialisent des choses truquées. Vous pouvez demander à quelqu'un de faire une vidéo où Mr X serait avec une dame Y... et tout cela, c'est construit. Les limites entre ce qui est réel et ce qui est fictif s'estompent. Et c'est très grave. Il faut réglementer cela.

Qui doit réglementer ? Les Etats ?

C'est aux gouvernements, aux institutions internationales de prendre leurs responsabilités. Il faut qu'il y ait un accord pour réglementer. Ce qui est très difficile à contrôler, c'est que ces engins ne sont pas prédictibles. Avec les réseaux neuronaux, la technologie sous-jacente, on ne peut pas prévoir. Il n'y a pas de théorie. Ces engins, on les entraîne, et puis ils font un travail.

Comment ça marche ? On ne comprend pas. Et si on ne comprend pas, on ne peut pas garantir par exemple leur objectivité, leurs propriétés, leur sûreté de fonctionnement, on ne peut rien garantir. Ce sont des systèmes qui ne fonctionnent pas comme les autres.

L'entreprise OpenIA, créatrice de ChatGPT, a identifié une liste de 34 métiers non-remplaçables, mais on va vers une dépendance accrue de l'homme envers ces machines à qui on va confier de plus en plus de tâches ?

Je pense que c'est le but de ces sociétés, de créer une dépendance et fidéliser un public. Je pense qu'actuellement le coût de fonctionnement de ces engins est très important, mais ils comptent sur une fidélisation des gens, et une dépendance des gens. Une recherche sur ChatGPT coûte en moyenne dix fois plus qu'une recherche Google. Il y a des aspects aussi qui concernent le coût énergétique de ces engins, quand on sait que les datas centers ont un impact sur le changement climatique parce qu'ils consomment beaucoup d'énergie. Il y a un débat là-dessus. Donc il faut voir le problème de manière globale. Il faut réglementer, comme vous réglementez l'accès des enfants à des films X, ou plein d'autres choses, l'achat de produits pharmaceutiques, de substances qu'il ne faut pas commercialiser, etc.

Ces engins peuvent faire des calculs et assembler des informations mais ils sont loin d'atteindre l'intelligence humaine.

Joseph Sifakis.

Pour vous quels sont les aspects positifs de l'intelligence artificielle ?

Les machines peuvent faire des choses extraordinaires en calculant plus rapidement que nous, et en ayant une capacité de mémoire plus importante. Mais il faut se mettre d'accord sur ce que cela veut dire être "intelligent". L'intelligence humaine a plusieurs aspects : c'est notre capacité à comprendre le monde, à s'adapter, à gérer plusieurs objectifs à la fois. ChatGPT ne peut pas conduire une voiture. Ces engins peuvent faire des calculs et assembler des informations mais ils sont loin d'atteindre l'intelligence humaine. Il faut relativiser tout cela.

Ce n'est pas la fin du progrès en matière de construction de systèmes intelligents. Et il faut contrôler. Il y a des personnes, y compris des signataires de la pétition, qui disent que les technologies vont nous détruire et que la technologie est maître. C'est l'homme qui va s'auto-détruire, c'est la responsabilité de l'homme de bien gérer la technologie. Il y a l'exemple du nucléaire : on peut faire de l'électricité ou des bombes atomiques. Il faut réglementer, donner un cadre d'utilisation de cette technologie, c'est aussi bête que ça.

Il y a une urgence à réglementer ?

C'est évident. Plus le temps passe, plus il sera difficile de contrôler ce phénomène. On aurait déjà dû se pencher sur la question. Il faut protéger les gens. Quand vous achetez un grille-pain, il y a une garantie, qui assure que c'est construit selon des normes et que l'appareil ne va pas vous tuer si vous l'utilisez proprement. Quand vous achetez un logiciel, il n'y a aucune garantie. Laisser faire tout cela conduit à des situations incontrôlables. On aurait dû le faire, il y a déjà 30 ou 40 ans, contrôler mieux ce qu'il se passe au niveau informatique, du point de vue de la qualité système, imposer des standards et des normes comme on impose des normes sur tous les produits industriels, sur les maisons, les ascenseurs, les avions."