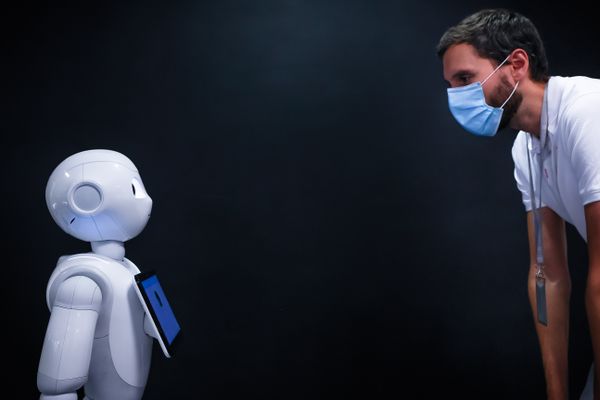

Alexei Grinbaum, physicien et philosophe, donne une conférence à 18 heures à Bastia sur "l'humain et l'inhumain de l'intelligence artificielle", alors que les robots prennent chaque jour plus de place dans notre vie. Parfois sans se soucier des risques possibles que cela représente. Entretien.

En1942, dans sa nouvelle Cercle Vicieux, l'auteur de science-fiction Isaac Asimov formulait les trois lois de la robotique auxquelles les robots qui peuplaient son œuvre romanesque devaient se soumettre : :

1 - Un robot ne peut porter atteinte à un être humain ni, restant passif, laisser cet être humain exposé au danger ;

2 - Un robot doit obéir aux ordres donnés par les êtres humains, sauf si de tels ordres entrent en contradiction avec la première loi ;

3 - Un robot doit protéger son existence dans la mesure où cette protection n'entre pas en contradiction avec la première ou la deuxième loi.

Près d'un siècle plus tard, les robots ne sont plus des machines sorties de l'imagination fertile d'un écrivain, mais une réalité. En 2021, nous sommes entourés par l'intelligence artificielle. Une avancée technologique qui a chamboulé notre quotidien, pour le meilleur. Et le pire ?

La place prise par les robots dans notre époque, des assistants vocaux de notre salon aux blocs opératoires, ne cesse de grandir. En conséquence, elle soulève un large panel de questions éthiques, au-delà de celles abordées par Isaac Asimov au siècle dernier. C'est le sujet de la conférence que tiendra Alexei Grinbaum ce samedi 2 octobre à Bastia, au centre culturel Alb'Oru. Une conférence organisée par a Casa di e scenze.

Entretien avec Alexei Grinbaum

- Les robots sont-ils faits pour nous aider à mieux vivre ?

On peut le dire. Il est bon, au préalable, de souligner l'utilité de ces systèmes. L'intelligence artificielle ne choisit pas sa propre finalité. Ce sont les concepteurs qui choisissent. Le panel est large, qui va du diagnostic médical à la sécurité, en passant par la reconnaissance faciale. Ces finalités sont censées nous faire du bien. Mais on peut avoir des surprises, ensuite. En découvrant des effets imprévus. Et c'est là que ça devient intéressant. Et que les questions d'éthique se posent.

- L'éthique a-t-elle sa place à une époque où on se livre à une course effrénée à l'innovation ?

Croyez-moi, on travaille à l'international, sur les cinq continents, et je peux vous garantir qu'ailleurs, on se questionne beaucoup moins qu'en France. Le pays est l'un de ceux qui s'interrogent le plus sur l'utilisation du numérique, les données à caractère privé, et d'innombrables autres sujets, tels que la voiture autonome, les entretiens de recrutement face à chatbot, un agent conversationnel intelligent...

Il faut que l'éducation, et la formation, s'adaptent aux besoins induits par la prépondérance de l'intelligence artificielle dans les prochaines années.

- Il y a aussi la question de l'emploi. Certains redoutent que les robots prennent la place des humains, dans les usines, les services...

C'est une évolution qui semble évidente, bien sûr. Une évolution à laquelle nous devons nous adapter. Mais ce n'est pas une catastrophe. Souvenez-vous des cochers, autrefois. Ils étaient des dizaines de milliers en France. Et l'apparition de l'automobile ne les a pas faits disparaître du jour au lendemain. La population des cochers a commencé à vraiment baisser à la fin des années 30. Cela laisse le temps de changer notre manière d'aborder les questions d'emploi.

- Cette évolution va aussi créer des métiers ?

C'est ça qui est important. Ce sont les métiers techniques qui vont être concernés. Il faudra des opérateurs pour ces systèmes, des contrôleurs pour s'assurer que la chaîne ne fait face à aucun problème... Mais le vrai défi, c'est de changer les programmes d'éducation et de formation suffisamment en amont, pour préparer les nouvelles générations à ce besoin de main-d'oeuvre nécessaire au bon fonctionnement des systèmes d'intelligence artificielle.

- Votre dernier livre s'intitule Les robots et le mal. Constituent-ils malgré tout une menace ?

Il y a ce mythe, récurrent, de l'intelligence artificielle qui va décider, par elle-même, d'exterminer la race humaine... Il faut être très clair, tous les systèmes sont fonctionnalisés. Ils font une chose, définie par les concepteurs. Ils ne peuvent pas changer de finalité, faire autre chose, de leur propre chef. Cette histoire d'extermination, de concurrence existentielle, qui revient de loin en loin, est une pure fiction.

L'intelligence artificielle n'est jamais responsable. Elle n'est ni une personne, ni un agent moral.

- Qui est d'ailleurs alimentée par les récits, livres et films de science-fiction, depuis des décennies...

Complètement. Il y a un autre mécanisme, en revanche, qui est celui de l'imitation mutuelle. Les machines apprennent en nous imitant, on le sait. Mais nous aussi, les utilisateurs, interagissons avec elles, et nous apprenons donc également d'elles. Nous avons appris, par exemple, à beaucoup mieux jouer aux échecs, ou au go. Les maîtres de go imitent les coups de go inventés par les machines. Dans un autre genre, si vous discutez avec un agent conversationnel longtemps, vous allez finir par parler un peu comme cet agent conversationnel. C'est cela, plus qu'une menace d'extermination, qui change notre condition humaine au sein du monde.

- C'est tout de même une menace, non ?

Une chose est sûre, il y a des usages envisagés, qui devraient être mis sur le marché dans les années à venir, qui vont profondément modifier notre condition humaine. Il y a un exemple parlant. l'humanité toujours été définie par sa finalité. Par la mort, et la conscience de cette mort future. Aujourd'hui, on sait faire des systèmes d'intelligence artificielle qui sont capables de parler comme des personnes décédées. De manière identifiable, ressemblante, mais sans pour autant faire le perroquet. Ces systèmes peuvent apprendre, à travers tout le corpus de messages, sur Whatsapp et ailleurs, que vous laissez derrière vous, à parler comme vous. Pourquoi ne pas, ensuite, imaginer un avatar qui parlera comme vous ?

La notion de volonté n'existe pas pour l'intelligence artificielle.

- On imagine qu'une telle chose donnerait naissance à des débats éthiques et moraux sans fin...

Voilà. Et pourtant, les premiers exemples de ce genre existent déjà. On l'a encore vu récemment au Canada. Ca pose une question : va-t-on changer la mort ?

- Les avancées de la science, et l'imitation, dont vous parliez tout à l'heure, peuvent-elles laisser redouter qu'un jour, le robot soit doué d'une vie propre ?

Il y a une différence, qui sera toujours là. C'est que les notions même de volonté, de conscience, n'existent pas pour les intelligences artificielles. Mais pour autant, elles peuvent se comporter, de manière inconsciente comme si elles étaient douées de volonté. Et un observateur extérieur sera dans l'illusion d'un comportement voulu. Il faut garder à l'esprit que s'il y a des problèmes qui apparaissent, ce sera par accident, pas de manière intentionnelle. Si on projette la responsabilité sur un système qui ne peut pas, par définition, être responsable, on se retrouve confronté à de vrais problèmes.

- Ca a été le cas en mars 2018, dans l'Arizona. Une femme a été renversée, et tuée, par une voiture autonome Uber. Cela soulève de nombreuses questions juridiques.

Exactement. La responsabilité doit être partagée au cas par cas. Dans ce cas-là, c'était un problème de reconnaissance d'image. Le système a vu qu'il y avait un obstacle, mais il l'a classifié comme quelque chose de pas important, pas comme un être humain. Il faut donc déterminer qui est responsable, entre les fabricants du système, les concepteurs de tel ou tel logiciel... C'est le tribunal qui tranchera. Mais ce qui est important, c'est de toujours avoir à l'esprit que ce n'est pas le système d'intelligence artificielle qui est responsable. Il n'est pas un agent moral, pas une personne.

- Est-ce que, si vous revenez en Corse dans une dizaine d'années, pour une nouvelle conférence, il est possible que ce soit un robot qui fasse votre interview ?

Ce n'est pas totalement exclu !

Biographie :

Alexei Grinbaum est physicien et philosophe. Après des études à l’Université de Saint-Pétersbourg et à l’Ecole Polytechnique, il soutient une thèse sur le rôle de l'information en théorie quantique. Il est aujourd'hui chercheur au Laboratoire des Recherches sur les Sciences de la Matière (LARSIM) du CEA-Saclay. Il travaille sur les questions éthiques et sociales que soulèvent les nouvelles technologies. Il étudie les incertitudes du progrès technique et leur impact sur la gouvernance, l’application du principe de précaution et la perception des innovations technologiques par le public.

Alexei Grinbaum est l'auteur de Mécanique des étreintes (Encre Marine, 2014), et Les Robots et le mal, (Desclée de Brouwer, 2019).

/regions/2021/09/29/615435c3683e2_7013183531-17175c522d-b-5472071.jpg)

/regions/2021/09/29/615435665a01c_12792132-238495226487781-4944648190181151664-o-5472065.jpg)

/regions/2021/09/29/615436d7d8111_32900283151-3ac5140d81-b-5472105.jpg)

/regions/2021/09/29/6154327128236_dpaphotosfive324544-5472031.jpg)

/regions/2021/09/29/61542d03412d4_csm-20210923-intel-artificielle-insta-bce2afd4db-5471991.jpg)